Stay Streaming Netflix als Infrastruktur: Über das proprietäre Distributionsnetzwerk Open Connect

Am 18. März 2020 informierte Thierry Breton die Öffentlichkeit über ein wichtiges Ferngespräch. Es hagelte Hashtags und Grußadressen. Via Twitter verlautbarte der EU-Kommissar für Binnenmarkt und Dienstleistungen («mit der erweiterten Zuständigkeit für Verteidigung und Raumfahrt»): «Important phone conversation with @ReedHastings CEO of @Netflix || To beat #COVID19 we #StayAtHome || Teleworking & streaming help a lot but infrastructures might be in strain. To secure Internet access for all, let’s #SwitchToStandard definition when HD is not necessary.» Eine Reduktion von Netflix’ Traffic schien plötzlich systemrelevant. Der angesprochene CEO wollte zwar keineswegs bestätigen, dass der Content des Anbieters den in Europa Zuhausegebliebenen von nun an als «poor image» (Hito Steyerl), in anachronistischen, kaum noch erinnerbaren 720 × 576 Pixel geliefert wird, gab aber immerhin zu Protokoll: «Netflix has decided to begin reducing bit rates across all our streams in Europe for 30 days. We estimate that this will reduce Netflix traffic on European networks by around 25 percent while also ensuring a good quality service for our members.» Nett von Netflix, sich so zu «entscheiden». Regulatorische Zwangsmaßnahmen standen der EU-Kommission auch nicht wirklich zur Verfügung.

Einen Downstream-Giganten, der 2019 für 12,6% des weltweiten Internet-Traffics verantwortlich war und zur abendlichen Prime Time Peaks bis zu 40% des Datenvolumens verursacht, aufzufordern, seine Datenlast soweit runterzufahren, dass ein infrastruktureller Systemkollaps vermieden werden kann, war zwar durchaus geboten, wirkte aber auch etwas verzweifelt. Die befürchtete Überlastung der Internet-Architektur bezog sich dabei weniger auf das pandemiebedingt gesteigerte Streamen von Serien im (bzw. statt) Home Office, sondern vor allem auf das erwartete Datenvolumen des «Teleworking» selbst. Erschwerend kommt diesbezüglich hinzu, dass viele Unternehmen aus Sicherheitsgründen die Dienste von Virtual Private Networks (VPN) nutzen, die die nun in lauter Außendienststandorte distribuierte firmeninterne Kommunikation verschlüsseln, IP-Adressen maskieren und den Datenverkehr über VPN-Server «tunneln», was den Weg durch das Internet um (mindestens) einen weiteren Schritt verlängert und insofern auch nicht gerade für Entlastung sorgt. Makroökonomisch leuchtete die Notwendigkeit einer Streamdatenreduktion als disziplinarische Maßnahme zur Pandemiefolgenbekämpfung natürlich unmittelbar ein: Im Home Office sollen allenfalls Zoom-Konferenzen gestreamt werden und kein digressiver Content. Statt erratischer Tigerkönige (Rezeptionswarnung: you cannot unsee it) oder dem melancholischen Scottie Pippen beim letzten Tanz mit dem überlebensgroß dauermotivierten Michael Jordan sollen auf den heimischen Screens Kalkulationstabellen, die mehr oder weniger intentional geteilten Bildschirme von Kolleginnen oder eben deren Konterfeis leuchten – gerastert und egalitär sortiert in der schnell ikonisch gewordenen «Galerieansicht».

Für das beruflich beanspruchte Streamen mag die technische Auflösung vergleichsweise nachrangig sein – wer will schon Gremiensitzungen in UHD (Vorteil allenfalls: die erhöhte Informationsdichte für Bücherwandforensik). Für Netflix hingegen ist die Auflösungsqualität als stabilisierter Übertragungszustand nicht nur Verkaufsargument und Kern der brand protection, sondern ein entscheidender Wettbewerbsvorteil im Zeitalter der durch den Launch von Disney+ und AppleTV+ tatsächlich ausgebrochenen «Streaming Wars». Dass die bereits 1996 von Bill Gates geprägte Formel «Content is King» nur die halbe Wahrheit ist (was einem Hersteller von Betriebssystemen nicht entgangen sein dürfte), lässt sich daran ablesen, dass Netflix nicht nur Infrastrukturen der Datenverteilung nutzt – und, Drosseln nach Drosten, temporär wesentlich entlasten kann, wenn sich Reed Hastings denn freundlicherweise dazu «entscheidet» –, sondern auch eigene Infrastrukturen besitzt und betreibt. Und zwar in Gestalt eines proprietären Content Delivery Networks (CDN), das (gewissermaßen wahrheitswidrig) «Open Connect» heißt.

Denn offen sind diese Datenleitungen nur für die Lieferungen eines einzigen Content Providers, dem es in jahrelanger Arbeit – der Aufbau begann 2011 – gelungen ist, ein exklusives Netzwerk in jenes Netzwerk einzuweben, aus dem das Internet, als «network of networks», als Ganzes besteht. Bei der Exklusivität geht es nicht um Content, sondern um jene «user experience», die der eigentliche «king» ist. Was also ist Open Connect und inwiefern hat Netflix’ proprietäre Infrastruktur der Bilddatenverteilung mit Auflösungsfragen, Streaming-Standards und der Zufriedenheit von derzeit rund 183 Millionen Subskribentinnen zu tun?

Streaming, um mit einer medientechnischen Definition zu beginnen, bezeichnet zunächst einfach nur, sozusagen contentagnostisch, ein Datenverteilungsverfahren, bei dem Übertragungs-und Wiedergabeprozesse zwar nicht ohne Rückstände zusammenfallen, aber spezifisch enggeführt werden. Aufbereitung und Präsentation des Datenmaterials werden (gleich, ob es sich etwa um Video- oder Audio-Streaming handelt) instanziiert, während laufend weitere Bestandteile des – nur in der Rückschau als solches fasslichen – Gesamtpakets empfangen werden. Medienfunktional gesprochen bedeutet dies: Streaming ist aus Sicht des Empfängers jenseits bestimmter Prozesse der Zwischenablage ohne unmittelbar evidente speichermediale Funktionalität. Das ist unter Effizienzgesichtspunkten erstmal erfreulich, es schont Speicherkapazitäten. Unter Computernetzwerkbedingungen verläuft die entsprechende Operation über eine medientechnische Gleichzeitigkeit, die sich vom klassischen wie vom sogenannten progressiven Download eines Files vor allem dadurch unterscheidet, dass auf der serveranfragenden Seite zu keinem Zeitpunkt eine vollständige Kopie des bezogenen Datensatzes existiert. Er strömt aus und fließt wieder ab: eine – heutzutage meist bitrateadaptiv rückgekoppelte – Doppelbewegung, die über den Transportkanal moderiert wird und erst seit Mitte der 1990er Jahre von den Rechen-und Zwischenspeicherleistungen allgemein verfügbarer Endgeräte prozessiert werden kann.

Mit dem Begriff adaptive bitrate streaming wird ein Verfahren bezeichnet, das voraussetzt, dass das zu übertragende Datenpaket, z. B. ein Video-on-Demand-File, in verschiedenen Qualitätsstufen encodiert ist (nämlich in unterschiedlich hoch komprimierten Auflösungen – was grundsätzlich auch für Live Streaming umgesetzt werden kann, wie das exzellent skalierbare multi-bitrate encoding der Videokonferenzplattform Zoom zeigt). Das Ziel dabei ist, dass das empfangene Zwischenprodukt – im Fall von Netflix: das videografische Bewegtbild – fließend und flexibel an die aktuell verfügbaren Datendurchsatzraten des Übertragungskanals angepasst werden kann – und zwar, darum geht es bei der «user experience», ohne ständig nachbuffern zu müssen oder gar abzubrechen. Die Adaptionsleistung zielt auf eine infrastrukturelle Stabilisierung, die zugunsten perzeptiver Kontinuität auf eine Flexibilisierung des Datendurchsatzes, des Übertragungsvolumens setzt. Streaming-Infrastrukturen sind grundsätzlich Infrastrukturen der Berechnung, kalkulierende, adaptive Infrastrukturen, die, während sie genutzt werden, ihre lokal- und zeitspezifischen Kapazitäten informationstechnisch beobachten, um in Feedbackschleifen Leistungskapazitäten der Übertragung rückzumelden. Am Front End sieht man davon meist nicht viel, aber immerhin: Wenn gebuffert werden muss, ist das ein Signal, dass die Adaption an ihre aktuelle Leistungsgrenze gerät.

Streaming unterläuft also umfangreichere Speichernotwendigkeiten der Clientanwendung durch einen Übertragungsvorgang, der Medienserverdaten nicht nur kontinuierlich anfragt, verteilt und entgegennimmt, sondern ebenso kontinuierlich verwirft. Dauerhafte Speicherung findet aber im Kontext von Streaming gleichwohl statt, nämlich auf Seiten des Content Providers, der seine Kunden auf verschiedenen Ebenen (und immer granularer) datafiziert, um Informationen, die sich auf den Datenbezug beziehen, durchaus langfristig speichern und nutzen zu können: für werbeökonomische Agenden des data mining, für kreativwirtschaftliche Entscheidungen bezüglich der Content-Entwicklung, -Gestaltung und -Präsentation, für Empfehlungsalgorithmen und sonstige Rückkoppelungen, die darauf abzielen, aus den individuellen Datennutzungsgeschichten der Subskribentinnen korrelative Datennutzungszukünfte prognostizieren und präfigurieren zu können.

Die Streamingtechnologien der Gegenwart stellen eine enorm prozessintensive Form der Übertragung dar, bei der auf verschiedenen Ebenen gerade bereits vor zugeschalteten Wiedergabeautomatismen fortlaufend Datenverarbeitung stattfindet. Entsprechend komplex und vielteilig ist Streaming als operativer und infrastruktureller Zusammenhang. Die infrastrukturelle agency ist verteilt: Die beteiligten Akteure reichen von «harten» Infrastrukturen wie Elektrizitäts- und Kabelnetzwerken, kühlungsbedürftigen Rechenzentren voller Servern und unterschiedlichsten Endgeräten über «softe» Infrastrukturen (Programmiersprachen, Programme, diverse Standards, Internetprotokolle und Formate wie MPEG) bis zu menschlichen Handlungsträgern (Programmierer, Service-Techniker).

Aus dieser Perspektive erscheint Netflix nicht einfach als monolithischer Anbieter überaus populärer Medieninhalte, der trotz eines aktuellen Schuldenstandes von 14,171 Milliarden Dollar allein 2019 unglaubliche 15 Milliarden nur für die Produktion von original content ausgab – bei einem ‹Corona›-Börsenwert von 187 Milliarden US-$ im April 2020 (erstmals gleichauf mit dem Disney-Konzern, der aktuell 186 Milliarden verzeichnet). Zum Vergleich: Das wertvollste deutsche Unternehmen liegt bei einer Marktkapitalisierung von 125 Milliarden Euro (SAP). Siemens, im DAX nach Linde drittplatziert, kommt derzeit auf rund 70 Milliarden. Netflix, auch das ist im spektakulären Börsenwert eingepreist, produziert nicht nur Content, sondern unterhält als Provider eine komplexe Medienökologie, die auf den Interface-Oberflächen einen beeindruckend cleanen Plattform-Effekt erzeugen mag, im Hintergrund aber de facto eine enorm distribuierte, proprietär betriebene Infrastruktur voraussetzt. Deren zentrales Element ist das Content Delivery Network Open Connect.

Kurz gesagt sind CDNs proprietäre Distributionsnetzwerke, die Nutzeranfragen über ein Request-Routing-System auf lokal verteilte Replica-Server umleiten, um insbesondere datenintensiven und zeitsensitiven Content mit Multimedia-Charakteristika wie Video-on-demand einer signifikanten Performance-Optimierung zu unterziehen. Worum es CDNs geht, ist eine Regionalisierung des Datenverkehrs: die Herstellung realräumlich kurzer Übertragungswege, die eine transportkostengünstige, stabile, unterbrechungsfreie, möglichst nicht auf massive Adaptionsleistungen – die eben über schwankende Bildauflösungen auch rezeptionsästhetisch bei den Endnutzerinnen ankämen – angewiesene Übertragung garantieren sollen.

Dazu muss der Medienserver, auf dem die kundenseitig angefragten Streamdaten, die Filme und Serien, physisch liegen, räumlich näher zum edge des Netzwerks, zum Klienten gebracht werden – und kann dann Probleme mit Latenzzeiten und instabilen Übertragungsraten kontrollieren.

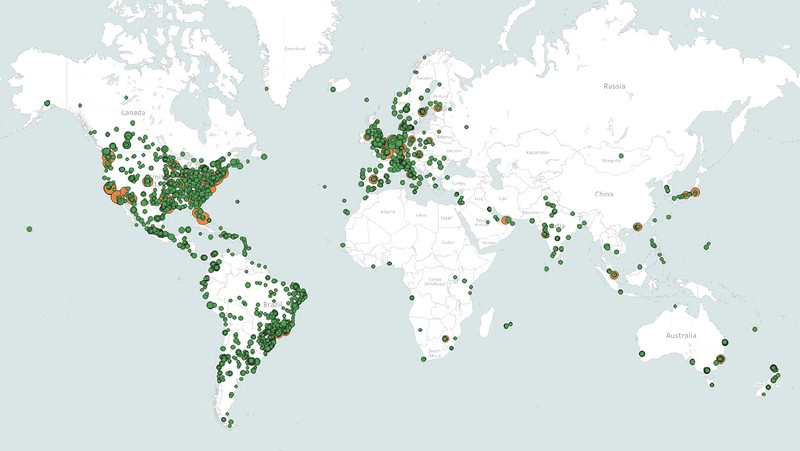

Open Connect Server-Stationen: bei Internet Providern (grün) und Internet Exchange Points (orange)

Die komplexe Content-Auslieferungsstrategie von Netflix unterscheidet sich im Detail von Region zu Region – so ist der indische Wachstumsmarkt bereits schwerpunktmäßig auf mobile streaming ausgerichtet (weltweit macht dieser Anteil derzeit bereits beachtliche 30% aus; 5G ist der allseits erwartete game changer) –, basiert aber grundsätzlich auf dem Prinzip einer Vielzahl lokal distribuierter Open Connect Boxen (über tausend derzeit: situiert in der Nähe großer urbaner Zentren, aber auch in Manaus, Okinawa, auf Malta oder im norwegischen Tromsø). Open Connect Boxen (siehe oben) sind exklusiv von Netflix verwaltete und genutzte Server oder, um es mit Gizmodo zu sagen: «badass connected hard drives», die in Off-peak-Zeitfenstern mit Inhaltskopien des regional am wahrscheinlichsten nachgefragten Contents bespielt werden, ansonsten aber bestrebt sind, interkontinentalen Traffic, der sich den begrenzten und volatileren Kapazitäten des transozeanischen Unterseekabelnetzwerks (siehe cargo 29) – also den eigentlichen pressure points des globalen Datenverkehrs – aussetzen müsste, zu minimieren.

Mit diesen Open Connect-Servern wird eine Subskribentin unter Maßgabe räumlicher Proximität direkt verbunden, nachdem sie, Streamingcontent beziehen wollend, den Play Button gedrückt hat. Jede Sekunde der zuletzt von Netflix ausgespielten rund 140 Millionen Wiedergabestunden pro Tag wird über Open Connect Server distribuiert, die eine Art Netzwerk innerhalb der Netzwerke von Internetdienstanbietern wie AT&T bilden. Dort, wo Internet Provider nicht bereit waren, die von Netflix aus strategischen Gründen kostenlos angebotenen Open Connect-Boxen in die jeweiligen Servernetzwerke zu integrieren (in den USA gab es etwa langwierige juristische Auseinandersetzungen mit Comcast, die sich derzeit strukturell ähnlich gelagert in Südkorea mit SK Broadcast wiederholen), ist der Streamingkonzern auf die Betreiber von Internet Exchange Points (IXP) ausgewichen, die meist kleinere Drittanbieter sind und nicht zu marktbeherrschenden Telekommunikationskonzernen gehören. In diesen Fällen sitzen die Open Connect Boxen buchstäblich an den Knotenpunkten der Internetinfrastruktur, nämlich dort – das meint Internet Exchange Point –, wo der Datenverkehrsaustausch zwischen den Netzen der einzelnen Internet Provider operationalisiert wird. So verfährt Netflix auch in Deutschland, wo die Open Connect Appliances (OCAs) bei IXP-Dienstleistern wie BCIX (Berlin), DE-CIX (Frankfurt), EXIC (Düsseldorf) eingepflegt sind.

Einerseits ist die Regionalisierung des Datenverkehrs, da Transportstrecken gekürzt und Netzwerke entlastet werden, durchaus im Interesse der infiltrierten Internet Provider. Andererseits würden sie Netflix das gewaltige Streamdatenvolumen, das dessen Subskribenten bei den Internet Providern verursachen, gerne extra in Rechnung stellen – was der Konzern aber, smarterweise im Rekurs auf eine Pro-Netzneutralität-Position, stets (und weitgehend erfolgreich) abgelehnt hat. Das Datenlastproblem bliebe ohne infrastrukturelle Antwort von Netflix oder den Internet Providern gleichwohl bestehen: Bei Globalstarts von beispielsweise der letzten Staffel einer Blockbuster-Serie wie THE CROWN, wenn in mehr oder weniger jeder Region Millionen von Abonnenten zur gleichen Zeit die gleichen Inhalte streamen wollen (in Spitzenzeiten bedeutet das ein Datenaufkommen mit zweistelligen Terabyte-Werten pro Sekunde), wäre ein Netzwerk der Inhaltsbereitstellung, das ausschließlich auf US-amerikanischen Servern, also global gesehen auch: auf den Übertragungskapazitäten des Unterseekabelnetzwerkes basiert, schnell überlastet (und die Transmission entsprechend kostenintensiv). Aus Sicht der Endkunden würde das Leistungsdefizit ohnehin weniger Netflix zugeschrieben werden als den ebenfalls Monatsgebühren einziehenden Internetdienstanbietern, die trotz vertraglich zugesagter Übertragungskapazitäten nicht in der Lage wären, stabile Streambilder auf die Schirme der Subskribenten zu liefern. Performance is king: Gerade das hat zur Kooperationsbereitschaft etlicher Internet Provider beigetragen, die nun in vielen Fällen Open Connect Boxen in ihren Serverräumen stehen haben.

Die kaum zu überschätzende ökonomische wie strategische Bedeutung der CDNs lässt sich unter anderem daran ablesen, dass Netflix im Zuge des Aufbaus von Open Connect entschieden hat, künftig nicht nur auf die bislang angemieteten CDNs von Akamai, Level 3 Communications und Limelight Networks zu verzichten, sondern auch sämtliche eigenen Datenzentren aufzugeben. Seit 2015 wird alles, was vor besagtem Klick auf den Play Button passiert (Logins, Interfaces, empfehlungsalgorithmische Katalogsortierungen, Kundendaten, Zahlungsverkehr etc.) über die Clouddienste von Amazon Web Services (AWS) abgewickelt – trotz der Konkurrenzsituation mit Amazon Video. Ist der Play Button jedoch aktiviert, bleibt AWS außen vor und die Streambilddaten strömen über Netflix’ eigene Infrastruktur Richtung Endkundin. Die Leistungsfähigkeit von Open Connect ist für jede Subskribentin unmittelbar wahrnehmbar und erzeugt einen fast unschlagbaren Wettbewerbsvorteil: Jedem Bahnkunden wird schon mal aufgefallen sein, dass Netflix auch unter den doch sehr bescheidenen Bedingungen des ICE-WLANs noch ziemlich stabil funktioniert, während andere Streamdienste aus dem Verzweiflungsbuffern kaum mehr rauskommen.

Aber welche Daten liegen nun wann, wie und warum auf den regional verteilten Open Connect Servern? Die meisten dieser Hard Drives enthalten 100–280 Terabyte Datenmaterial. Wer mag, kann also anfangen zu rechnen: Wenn man davon ausgeht, dass ein HD-Stream in bestmöglicher Qualität typischerweise 3 Gigabyte pro Stunde mit sich bringt, heißt das, dass 200 Terabyte Datenmaterial rund 136 000 Stunden HD-Video-Streammaterial umfasst (5688 Tage HD-Content von Netflix) – und wer nach den realräumlichen Dimensionen dieses Infrastrukturbauteils fragt: die 200 TB liegen tatsächlich auf dem Festplattenspeicher eines physischen Objekts, das kaum größer ist als ein handelsüblicher Desktop-PC der 1990er Jahre (aber doch deutlich schwerer).

Der effiziente Betrieb des Open Connect-CDNs basiert dabei wesentlich auf einer algorithmischen Prognostik: Auf den Servern, die Netflix an verschiedenen lokalen Punkten in das Netzwerk der Internetdienstanbieter bzw. der Internet Exchange Point-Betreiber eingeschleust hat, liegen nämlich immer nur Kopien jener Teile des Netflix-Gesamtkatalogs, von denen algorithmische Modellierungen auf Basis von Nutzerstatistiken prognostizieren, dass sie lokal nachgefragt sein werden.

Der Longtail des Katalogs liegt weitgehend auf US-basierten Servern, die den Gesamtkatalog enthalten und Transcodierungsrepositorien genannt werden. Wenn man auf einen solchen sehr selten nachgefragten Inhalt beispielsweise von Kreuzberg aus zugreift, kommen die Daten nicht von dem Open Connect-Server, der bei BCIX Berlin, direkt neben der Tempelhofer IKEA-Filiale steht, sondern tatsächlich via Unterseekabel von einem US-Server, der den Gesamtbestand verwaltet.

Die Algorithmen, die sicherstellen sollen, dass zur richtigen Zeit die richtigen Daten auf dem richtigen lokalen Server liegen, wurden parallel zu den sogenannten Empfehlungs-bzw. Personalisierungsalgorithmen entwickelt (siehe dazu cargo 36), die Subskribentinnen individuelle Inhalte vorschlagen, um sie nicht aus der hermetischen Streambubble zu entlassen. Grundsätzlich lässt sich sagen, dass die Art und Weise, wie Netflix auf den Interface-Oberflächen den eigenen Katalog sortiert und personalisiert, mit den Vorabspeicherungsverfahren, die Inhaltskopien auf lokale Open Connect-Server liefern, verschaltet ist. Denn im Grunde kann Netflix über die Empfehlungsalgorithmen, die die Katalogbestände nicht einfach neutral verwalten, sondern aufmerksamkeitsökonomisch hierarchisieren, nicht nur antizipieren, sondern auch ein Stück weit mitsteuern, was denn nun der nachgefragteste Inhalt sein wird.

Was sich dabei grundsätzlich auch zeigt: Streambilder sind insgesamt weniger stabile Objekte als Zwischenergebnisse infrastruktureller Kalkulationsvorgänge, also nur im bzw. als Fließzustand beschreibbare Prozesse. Überhaupt ist zu konstatieren, dass digitale Infrastrukturen profunder als vor- oder nicht-digitale von informationstechnischen Berechnungsvorgängen abhängen. Im Fall von Streaming sind dies nicht nur Algorithmen, die wahrscheinliche Inhaltsnachfragen für die effiziente Off-peak-Bespielung von CDN-Replica-Servern prognostizieren oder Katalogbestände empfehlungsalgorithmisch personalisieren, sondern insbesondere auch Kompressionsalgorithmen, die bei Netflix ebenfalls auf avancierte Weise adaptive sind.

Im Kontext von Streaming zielen Kompressionsalgorithmen allgemein darauf ab, die Übertragung zu optimieren, genauer: Transmissionsinformationen zu minimieren. Gerechnet wird also auch hier mit einem Parameter, der für Bauweise und Betrieb von Infrastrukturen generell zentral ist: Transportkosten. Um diese zu reduzieren, gilt es, das Transportgewicht von Multimediadatenpaketen zu optimieren – eine effizienzgeleitete Kalkulation, die gleichermaßen der Schonung von Speicher- und Übertragungskapazitäten dient. Was hier vor allem berechnet wird, sind jene in Videobilddatenpaketen enthaltenen Redundanzen, auf deren Distribution zugunsten optimierter Bitraten verzichtet werden kann. Die Identifizierung geeigneter – da von menschlichen Nutzern kaum perzeptierbarer – Redundanzanteile vollzieht sich grundsätzlich vor dem Hintergrund einer langen Geschichte des perceptual engineering: Encodiert wird insofern immer auch ein spezifisches Wahrnehmungswissen, das in Bezug auf audiovisuelle Datenverarbeitung eine bis in die Frühgeschichte des Fernsehens zurückreichende Genealogie aufweist.

Die technischen Details sind jedoch auch hier nicht unkompliziert. Digitale videografische Kompressionsverfahren reduzieren zum einen jene Luminanz-und Chrominanzwerte, die innerhalb eines bestimmten Frames als nicht oder kaum perzeptierbar eingeschätzt werden – wobei das menschliche Auge Farbinformationen grundsätzlich weniger differenziert bzw. aufgelöst wahrnimmt als Helligkeitswerte, weshalb hier größere Einsparpotenziale bestehen. Das Standard-Videoformat MPEG adressiert neben diesen räumlichen Redundanzen, die Nachbarschaftsverhältnisse von Pixelblocks innerhalb eines Frames im Sinne möglicher Nivellierungsspielräume, also verlustbehaftet (lossy) berechnen, aber vor allem die Inter-Frame-Ebene. Das Ziel ist in letzter Instanz immer dasselbe: Daten zu identifizieren, die bei relativ gleichbleibender Bildqualität nicht mehrfach übertragen werden müssen. Es geht bei Kompressionsalgorithmen also anders gesagt um Bildanteile bzw. Bitmap-Bewegungsmuster, die sich innerhalb einer Sequenz von Frames nicht oder lediglich so minimal verändern, dass es nicht weiter auffällt, wenn sie nur einmal übertragen werden. Je größer die Ähnlichkeit der Bildpunkte innerhalb eines Frames, je geringer die Mobilität der Bildpunkte zwischen den Frames, desto effizienter aus Sicht der Transferkosten.

Operationalisiert wird diese kompressionsorientierte Transportkostenkalkulation von Codecs – das sind Algorithmenpaare, die digitale Datenströme encodieren und decodieren. Und auch mit Blick auf die spezifischen kompressionsalgorithmischen Anforderungen von Videostreaming zeigt sich, dass Netflix eine Vorreiterrolle einnimmt – und zwar bezüglich der flexiblen Encodierung der Streaminginhalte.

Grundsätzlich bietet Netflix seinen Content in verschiedenen Qualitätsstufen an, je nachdem, ob dem Endkunden ein langsames DSL, eine Mobilfunkverbindung oder ein Glasfaseranschluss zur Verfügung steht. Bildtechnisch präzisiert: Das Spektrum reicht von 235 kBit/s für eine Bildauflösung von 320 × 240 Pixel, über 1.750 kBit/s bei 1.280 × 720 Pixel, bis hin zu 5.800 kBit/s für die standardisierte HD-Qualität von 1.920 × 1.080 Pixel. 4K bzw. UltraHD – die Benchmark der nahen Zukunft, weshalb Netflix auch hier wieder auf den «first-mover advantage» setzt – bedeutet 3.840 × 2.160 Pixel, was derzeit einer rund dreimal höheren Bitrate von 15,6 MBit/s entspricht. Zudem existieren eine ganze Reihe von Zwischenschritten, weil, wie erwähnt, Streamingbildqualität während des Übertragungsvorgangs adaptiv und möglichst gleitend an die vorgefundenen Verbindungskapazitäten angepasst wird.

Konkret bedeutet das für die Speichereinheiten des CDNs: Auf den Open Connect-Servern liegt eine Episode von The Crown nicht einfach als eine große Gesamtdatei, sondern zigfach, in verschiedensten Versionen, nämlich gestaffelt nach Auflösungsstufen. Deshalb werden Hard Drives mit 100 bis 280 TB benötigt: nicht weil der Netflix-Katalog so tief wäre (wobei er, über alle per Geoblocking separierten Subkataloge verteilt, immer noch rund 14 000 Titel umfasst), sondern weil der gesamte Content kompressionstechnisch hochgradigst versioniert bereit liegen muss – nämlich in bis zu 120 verschiedenen «recipes», wie es in der Codiersprache heißt.

Damit nicht genug. Bis 2015 hat Netflix mit fixen Bit-Raten gearbeitet, also alle Inhalte kompressionsalgorithmisch gleich prozessiert – egal, ob es sich um einen bildtechnisch wie bildästhetisch komplexen, informationsgesättigten Content (eine aufwändig produzierte Blockbuster-Serie mit viel Kamerabewegung und CGI) oder um eine in bildtechnischer Hinsicht vergleichsweise datenarme Animationsserie wie Bojack Horseman gehandelt hat. Mit ersterer hat der Open Connect-Server deutlich mehr zu tun, weil die Inhalte Frame für Frame ein größeres Datenvolumen aufrufen, größere Inter-Frame-Differenzen mobilisieren und deshalb höhere Bitraten erfordern bzw. stärker komprimiert werden müssen – worunter dann die wahrgenommene Bildqualität leidet.

Auf dieses Defizit an Differenzierung hat Netflix vor drei Jahren mit sogenannten adaptiven Kompressionsalgorithmen reagiert, die ebenfalls hausintern entwickelt wurden und industrieweit als innovative proprietäre Software gelten. Dabei handelt es sich um Algorithmen, deren Operationen sich nicht auf die Verbindungsqualität (die Beobachtung dieser und die Anpassung an diese) beziehen, sondern auf die ästhetische und informationstechnische Struktur des Quellenmaterials selbst, das es zu streamen gilt. Seit 2016 kann Bojack Horseman nun auch in 1080p bei einer Bitrate von 1,5 MBit/s gestreamt werden – zuvor waren für HD, egal um was für einen Content es sich handelte, wie gesagt 5,8 MBit/s nötig, also fast die vierfache Datenmenge – oder anders gesagt: Bei einer verfügbaren Bitrate von 1,5 Mbits wäre der Inhalt bis dahin eben nur in 720p gestreamt worden.

Um diese suboptimale Gleichbehandlung zu differenzieren, wurde in einem ersten Schritt der gesamte Netflix-Katalog neu encodiert. Für jeden Einzelfall war zu entscheiden, welche inhaltsadaptive Kompressionsencodierung zur Anwendung kommen soll. Und es geht noch weiter: Seit kurzem wird die Kompression auch innerhalb eines Datensatzes, innerhalb einer Episode oder eines Films adaptiv differenziert. Wenn sich also beispielsweise datenintensive Schlachtenszenen und kammerspielartige Sequenzen in dunklen Räumen – die datenarm und leicht zu komprimieren sind, weil sich zwischen den Frames vergleichsweise wenig Differenzgeschehen, wenig Pixelwandel ereignet – abwechseln, dann sind entsprechend verschiedene kompressionsalgorithmische Encodierungsmodi am Werk, die die Sequenzen variabel komprimieren – und das wiederum für alle recipes. Man kann sich leicht vorstellen, dass für all diese Prozesse ziemlich viel Komputationsressourcen in Anspruch genommen werden müssen.

Dass Netflix-Content in Europa auch in Corona-Zeiten, anders als Thierry Breton verkündete, nur in absoluten Ausnahmefällen anbieterseitig auf SD-Auflösungen runtergefahren wurde, verdankt sich in erster Linie der Option effizient hochregulierbarer kompressionsalgorithmischer Adapationsleistungen. Was sich auch zeigt: Die infrastrukturelle Adaptivität des von Netflix operationalisierten Streambildtransports reicht von der in mikrozeitlichen Intervallen durchgeführten algorithmischen Messung physisch verfügbarer Übertragungskapazitäten über die adaptiven Feedbackschleifen flexibler Datendurchsatzraten bis zu kompressionsalgorithmischen recipes, die die bildästhetischen Inhalte informationstechnisch durchmustern und differenzieren, um, je nach ‹Informationsdichte› (gemeint sind wiederum die Pixel-Differenzen innerhalb eines Frames und der Pixelwandel zwischen den Frames), adaptive Encodierungen zur Übertragung anfordern und schließlich – erst dann materialisiert sich das digitale Streambild auf konkreten Screens – strombegleitend decodieren zu können.

Netflix’ enorme Infrastrukturmacht bedeutet auch, dass Datenmaterial von Content-Anbietern, die keine eigenen Distributionsnetzwerke unterhalten und auf den Service anmietbarer CDNs verzichten, zwar weiterhin übertragen wird und zirkuliert – aber in einer gewissermaßen zweitklassigen, vergleichsweise entschleunigten, wesentlich störanfälligeren Umlaufbahn. Weil CDNs den globalen Bilderstrom nach zirkulativen Reichweiten, nach abgestuften Signallaufzeiten und Stabilitätsparametern differenzieren, haben sich trotz Netzneutralität zunehmend problematische Verteilungshierarchien herausgebildet. Bei den «Streaming Wars», die unter den aktuellen Vorzeichen einer pandemiebedingten Schließung von Kinos, Bars, Konzerthallen, Nachtclubs nochmals nachhaltiger ins Zentrum der Kämpfe um Marktanteile in der Medien-und Unterhaltungsindustrie gerückt sind, geht es deshalb nicht einfach nur um die «tiefsten» Kataloge, die größten Stars, die besten Creators und die meisten Emmys, nicht um den «qualitativ» unschlagbaren original content, sondern gerade auch um die leistungsfähigsten Infrastrukturen der Streamdatenverteilung (Netflix plant, den bereits relativ konsolidierten Wettbewerbsvorteil in naher Zukunft durch den Einstieg in einen subskriptionsbasierten Game-Streaming-Service weiter zu monetarisieren).

Während Disney für die Streamingdienste Disney+ und ESPN+ bereits 2017 den Technologiekonzern BAMTech akquirierte (der auf AWS und Amazons CDN CloudFront aufbaut und beim überaus erfolgreichen Start von Disney+ gleich an seine Leitungsgrenze geführt wurde), waren Marktbeobachter zuletzt vor allem von Apple beeindruckt, dessen Streamingangebot katalogseitig noch bescheiden sein mag, derzeit aber das beste, nämlich robusteste und datenintensivste 4K-Streaming liefert – auf der Basis eines hauseigenen CDN, das auch die iCloud Services und Apple Music bedient. Wie gut Apples Streamingtechnologie skalierbar ist, wird allerdings erst die Zukunft zeigen.

Was sich immer deutlicher abzeichnet: Unabhängig von letztinstanzlichen Fragen der Netzneutralität – für die Netflix eintritt, weil Open Connect eine auf dem netzneutralen Best-Effort-Prinzip basierende Lösung darstellt – gibt es in der schönen neuen Welt des Streaming längst buchbare Überholspuren und Expressversandoptionen, eine Differenzierung der Datenleitungen, die sich als variable Mobilität, Stabilität und eben mehr oder weniger komprimierte Auflösungsqualität der Content-Auslieferung manifestiert. Dass sich die kartografische Verteilung des CDN (siehe oben) auf Standorte in Nordamerika, Europa und in Südamerika vor allem Brasilien konzentriert, während in Afrika ein Internet Exchange Point-Betreiber in Johannesburg, der lediglich acht Open Connect-Boxen verwaltet, schon die leistungsfähigste Station ist, zeigt, wie deutlich Netflix’ Infrastrukturen den digital divide der Gegenwart widerspiegeln und verstärken.

Nicht nur ist Netflix als auf Filme und Serien spezialisiertes Medienunternehmen auf eine Weise vertikal integriert, die nach dem mittlerweile von Kartellaufsichtsbehörden offenbar völlig vergessenen Anti-Trust-Urteil des Paramount Case (1944) jahrzehntelang unvorstellbar schien. Von den granular verdateten Konsumenten bis zur proprietären Abriegelung exklusiv konzerneigener Streaming-Infrastrukturen ergibt sich, ähnlich wie bei Disney und den anderen Oligopolisten, eine fast vollständig geschlossene, gegen um Transparenz bemühten Einblick abgeschottete Produktkontrolle. Mit der marktwirtschaftlichen Idee eines «level playing field» haben die Streaming Wars entsprechend wenig zu tun.

Ähnlich bedenklich steht es um den erheblichen Carbon Footprint, den Video Streaming mit sich bringt und dessen «unsustainability» von Think Tanks wie The Shift Project schon seit einiger Zeit angemahnt wird. So hat Laura Marks in einem Blog-Beitrag für das Harun Farocki-Institut kürzlich annäherungsweise vorgerechnet, wie es um die Klimabilanz von Netflix’ bizarrer True Crime-Serie TIGER KING bestellt ist, die in den ersten zehn Märztagen allein in den USA 34 Millionen mal gestreamt wurde.

Bei einer angenommenen Auflösung von 1080p kommt die durchschnittliche Zuschauerin demnach auf eine geschätzte Datenlast von 2,92 GB und einen Energiebetrag von 14,6 kWh (wenn man, was sofort einleuchtet, davon ausgeht, dass jede Zuschauerin nur ein Viertel der Serie übersteht). Das Ergebnis liegt dann bei einer halben Terawattstunde, was Marks zufolge dem Stromverbrauch Ruandas im Jahr 2016 und den Jahresemissionen von 75 834 PKWs entspricht – oder einem Kohlenstoff-Fußabdruck, der durch etwa 6 Millionen Baumsetzlinge, die 10 Jahre lange wachsen, ausgeglichen werden müsste. Aber Hauptsache die «user experience» stimmt, wie es in Deichkinds Cliffhänger heißt: «Can’t stop streaming, can’ stop streaming || Can’t stop – streams are my reality».