F for Deepfake Diese Person existiert nicht (refresh)

Fragt man den Urban Dictionary, was die popkulturell gut eingeführte Replikformel «That’s deep» bedeutet, erhält man folgendes Definitionsangebot: «A turn of phrase generally used by people who feel the need to comment on something and yet at the same time have absolutely no idea what they just read but would like to come off as intelligent.» Auch das sozialmediale Anwendungsbeispiel leuchtet unmittelbar ein: «Poster: ‹We felt we were doomed to die and say how powerless we were to help ourselves; but that was good, for then we put everything into the hands of God, who alone could save us.› (II Corinthians 1:9) > Comment from someone: ‹That’s deep›.» Spätestens wenn man sich diesen Kommentarjemand in stimmlicher Verkörperung durch Seth Rogens seinerseits tiefergelegten Trademarkbassbariton vorstellt, wird klar: so deep ist das alles auch wieder nicht (und retten wird uns sowieso eher niemand).

Innerhalb des ausdifferenzierten Spektrums digitaler Bildfälschungspraktiken verweist die rezente Popularisierung sogenannter Deepfakes aber gleichwohl auf eine Vertiefung qua Automatisierung, die sich zunehmend als ironieresistent erweist. Was mit spielerischen Gesichtsbildfusionsspäßen von Instagram Accounts wie «Gesichtermix» (Anspieltipp: Volker Beck meets Bryan Cranston; Jürgen Trittin koaliert doch noch mit Wolfgang Kubicki) oder jenem der «virtuellen Influencerin» Imma vergleichsweise harmlos begann, sich dann aber relativ schnell in überwiegend misogyne Bahnen kanalisierte (worüber Face-Swap- Porn-Opfer Scarlett Johansson neulich die Washington Post aus Betroffenenperspektive informierte), ist mittlerweile beim nochmal anders unheimlichen Output «unüberwacht lernender» Algorithmen angekommen.

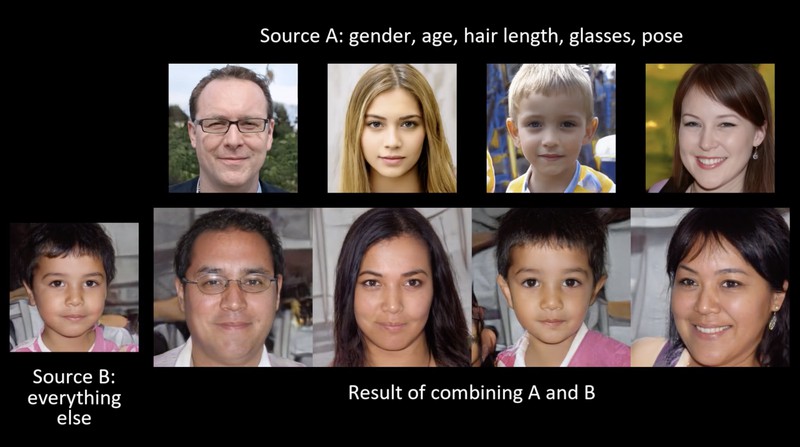

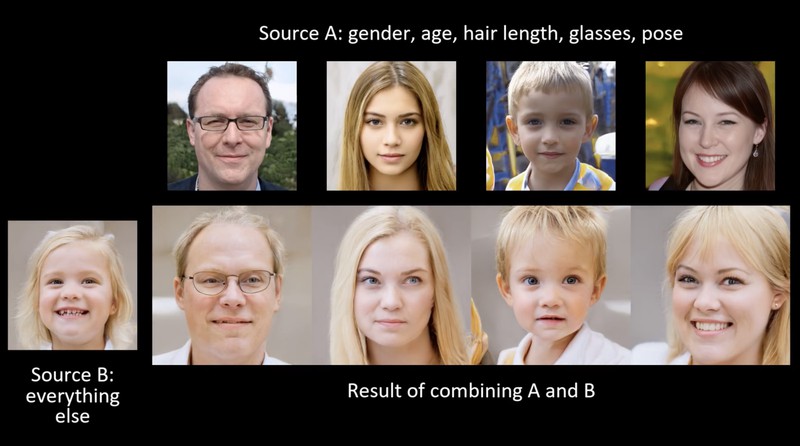

Deep wird der Fake hier begriffslogisch insofern, als die Bildfälschungsperformanzen nun auf der Basis künstlicher neuronaler Netze operieren. Wie im zuletzt aufsehenerregenden Fall von StyleGAN aus dem Hause NVIDIA handelt es sich dabei um Generative Adversarial Networks, bei denen das algorithmische Trainingsdaten- nullsummenspiel vereinfacht gesagt zwei gegeneinander antretende Netzwerke kooperativ aneinanderbindet. Das eine Netzwerk generiert mit wachsender Begeisterung (und Kompetenz, man lernt ja als KNN nie aus) gefakte – das meint hier, sagt der Realist in uns: faktisch referenzlose, pseudoindexikalische – Porträtbilder in fotografischer Ästhetik und zunehmend hoher Auflösung, während das andere Netzwerk gleichermaßen unermüdlich Outputbewertungen komputiert. Per Feedback der Testergebnisse soll der Generator motiviert werden, nicht nur unaufhörlich neue, sondern vor allem immer bessere, also täuschend ‹echtere› Porträtbilder zu erzeugen, die durch den bewertenden Diskriminator, so die Lernerfolgsformel, immer schwerer von nichtgefakten Fotoporträts – was auch immer das in Zeiten ubiquitärer Bildsoftware genau sein soll (und als Rückfrage an die ‹Echtheit› der auf sozialmedialen Fotoplattformen eingesammelten Trainingsdaten nochmals andere Probleme aufwirft) – unterschieden werden können.

Kann uns jetzt nur noch Gott helfen? Mediengeschichtlich betrachtet ließe sich natürlich mit Gelassenheit einwenden, dass das skeptisch beäugte Fälschungs- und Täuschungspotenzial neuer Medien immer auch neue medienforensische Kompetenzen des kritischen Gegenlesens und Reevaluierens mit sich gebracht hat und bringt. In medientechnischer Hinsicht handelt es sich aktuell ohnehin um ein Szenario, in dem nicht nur Bildfälschung und Bilderkennung, sondern auch Bildfälschungsdetektion deep geht, wie das auf digitale Bildforensik spezialisierte MediFor-Programm von DARPA (dem Forschungszentrum des US-Verteidigungsministeriums) oder avancierte fotodaktyloskopische Projekte wie Photo-DNA und eGlyph nahelegen. Was jenseits softwaretechnischer Routineinterventionen handelsüblicher Fotoapplikationen manipuliert wurde oder, der Gipfel des Falsch, nie und nimmer echt war, soll hier in den Tiefenstrukturen der Bilddaten erkannt, automatisch ausgeflaggt und perspektivisch aus dem Verkehr gezogen werden. Also einfach Zurücklehnen, weil Hochrüstung auf allen Seiten und insofern Gleichgewicht des Schreckens?

Dass sich gerade auch informationstechnisch versierte menschliche Beobachter der maschinellen Bildfälschungsselbstlerner langsam aber sicher Sorgen machen, weil fotorealistisch codierte Deepfakes immer saum- und spurloser, immer zielgenauer (nämlich bildebenendiskret) und zudem auch autonomer operieren, hat der von Uber zu NVDIA gewechselte Programmierer Philip Wang unlängst in einem Facebook-Post publik gemacht, mit dem er auf die zu didaktischen Zwecken aufgesetzte Webseite thispersondoesnotexist.com hinweisen wollte. Per Refresh Button kann man sich hier beliebig viele ad hoc generierte, konventionell fotorealistisch gebaute Porträts nicht existierender Personen ansehen. Bilder von Menschen wie du und ich. Aber eben nur fast. Ein bisschen uncanny wird das nach einer Weile mit Blick auf die Ansage der URL schon, auch weil der dahinter stehende Werkzeugkasten zunehmend jenseits einzelbildbezogener Gesichtsporträtfälschung – etwa im Zugriff auf komplexere videografische Sequenzen oder in der Kombination von dynamischer Gesichtsumwandlung, Objekteinbauten und fake audio – ziemlich mikromanipulativ, invasiv und gestaltungsoffen zu sein scheint, was bei dystopisch veranlagten Zeitgenossen die Frage aufwerfen mag, ob in naher Zukunft irgendeine dieser Nichtpersonen amerikanischer Präsident werden und in CNNs überkandidelt retrodesigntem Virtual Reality-Studio beispielsweise einen atomaren Erstschlag verkünden könnte. Was ja dann doch ziemlich deep wäre.